Деякі SEO-помилки критично небезпечні й можуть звести всі зусилля нанівець. Одна з таких - дублі сторінок. Вони вкрай негативно сприймаються пошуковими роботами й істотно ускладнюють пошукове просування сайту. Тому важливо прибрати дублі сторінок на сайті якомога швидше.

Чому це так важливо?

Коли на веб-сайті є дві однакові сторінки, пошуковики не можуть зрозуміти, яку з них потрібно показувати користувачам за релевантним запитом. І навіть з огляду на те, що боти вивчають й інші параметри, їм все одно важко вирішити, який із дублів потрібно обирати.

Тому потрібно знайти і закрити дублі сторінок сайту, інакше ви зіткнетеся з проблемами:

- може знизитися рейтинг усього веб-сайту;

- зниження позиції ключових фраз;

- стрибки позицій через те, що система постійно змінює релевантність між кількома сторінками.

Види дублікатів

Щоб ефективно шукати дублі сторінок і позбавлятися від них, потрібно знати, яких видів вони бувають.

Існує два типи:

- повні дублікати - копія сторінки, розміщена на різних URL-адресах;

- часткові - дублюється частина вмісту.

Повні дублі

Це може бути:

- однакові сторінки за однаковими URL адресами з www і без;

- дублі сторінок з html і https;

- копії, створені через реферальні посилання;

- проблеми з ієрархією розділів, які генерують копії;

- неправильно налаштована сторінка 404, що створює дублікати;

- дублі сторінок без слеша в кінці url.

Часткові дублі

Вони зазвичай з'являються через особливості системи управління сайтом, і знайти їх складніше.

Найчастіше це:

- Копії, створені сторінками фільтрів, сортувань і пагінації. Наприклад, коли користувач застосовує фільтр товарів, URL адреса трохи змінюється, і пошукові роботи індексують цю сторінку як окрему. Але від зміни адреси в цьому випадку контент не змінився.

- Блоки коментарів і описів. Тут практично та сама ситуація - перехід до блоку відгуків, наприклад, створює додатковий параметр в адресі, але сторінка залишається та сама.

- Друк і PDF для завантаження. Такі сторінки повністю копіюють вміст веб-сайту.

- Згенеровані AJAX зліпки сторінок.

Як виявити копії?

Можна перевірити сайт на помилки кількома способами:

Промоніторити видачу за допомогою оператора "site:"

Це метод, що дає змогу перевірити дублі сторінок сайту вручну. Видачу, відфільтровану оператором, потрібно вивчити візуально і виявити копії.

Програми

Існують різні інструменти для веб-майстрів, що дають змогу швидко просканувати веб-сайт. Це може бути перевірка сайту на дублі сторінок онлайн або за допомогою десктопних програм. Вони вивантажать повний список адрес, який можна буде потім відсортувати і знайти дублікати.

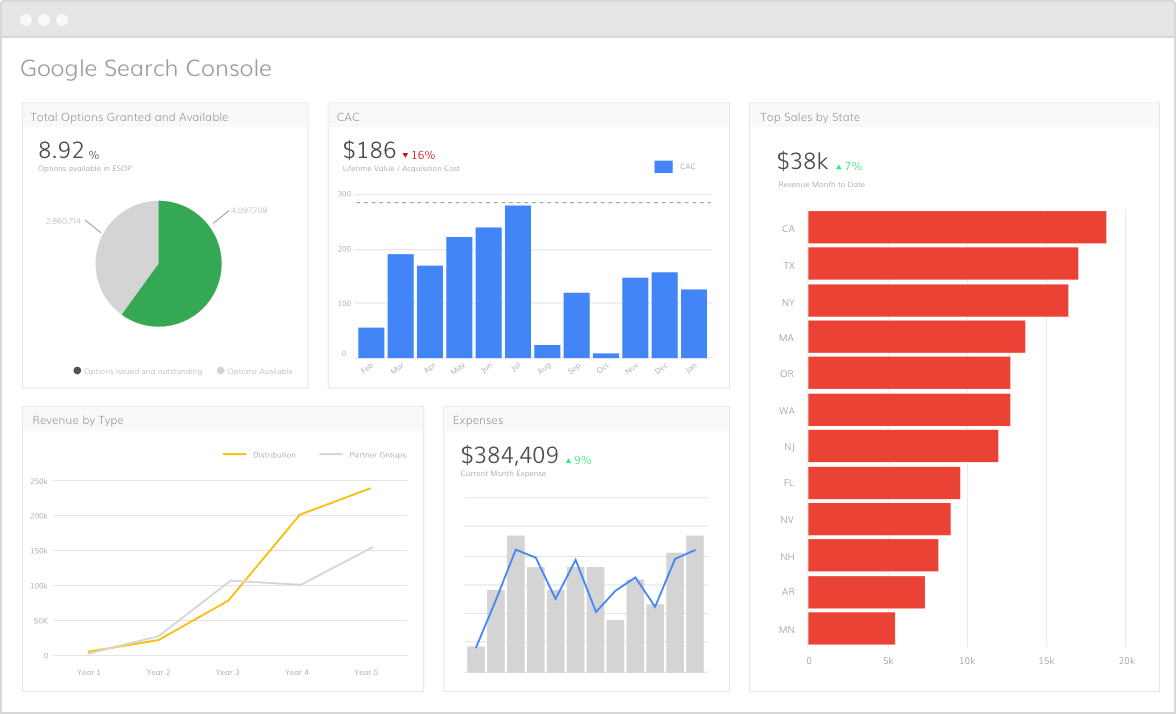

Консоль Google

Google Search Console відображає список повторів мета-описів і тегів. Вони можуть бути ознаками копій.

Як позбутися дублікатів?

Перший і найочевидніший метод - видалити дублі сторінок зі слешем та іншими частинами URL адреси, які створюють копії. Також можна заборонити роботам індексувати дублікати, дописавши умови у файл "robots.txt". Це спрацює зі службовими сторінками, які повторюють вміст основних.

Ще одне рішення - налаштувати 301 редирект зі сторінки-дубля на відповідну коректну сторінку сайту. Це допоможе з помилками в ієрархії розділів і reff-мітками. Також можна проставити тег "rel=canonical", що розв'яже проблему з фільтрами, сортуванням і пагінацією. А якщо у вас на веб-сайті є версії для друку, блоки з відгуками та іншою інформацією, скористайтеся тегом meta name="robots" content="noindex, nofollow". Це дасть змогу приховати подібні блоки від пошукових ботів.

Найчастіше копії створюються самою системою управління сайтом, тому краще, щоб виявленням дублікатів і їх усуненням займався досвідчений фахівець. Наша команда веб-студії Артджокер має великий досвід і міцні знання в пошуковій оптимізації та просуванні сайтів. Ми зможемо виявити всі помилки, які заважають розкручуванню вашого ресурсу, і виправити їх. Також ми складемо ефективну стратегію просування, яка дасть змогу швидко досягти бажаних результатів.