Некоторые SEO ошибки критично опасны и могут свести все усилия на нет. Одна из таких - дубли страниц. Они крайне негативно воспринимаются поисковыми роботами и существенно усложняют поисковое продвижение сайта. Поэтому важно убрать дубли страниц на сайте как можно быстрее.

Почему это так важно?

Когда на веб-сайте есть две одинаковых страницы, поисковики не могут понять, какую из них нужно показывать пользователям по релевантному запросу. И даже учитывая, что боты изучают и другие параметры, им все равно трудно решить, какой из дублей нужно выбирать.

Поэтому нужно найти и закрыть дубли страниц сайта, иначе вы столкнетесь с проблемами:

- может снизиться рейтинг всего веб-сайта;

- снижение позиции ключевых фраз;

- скачки позиций из-за того, что система постоянно меняет релевантность между несколькими страницами.

Виды дубликатов

Чтобы эффективно искать дубли страниц и избавляться от них, нужно знать, каких видов они бывают.

Существует два типа:

- полные дубликаты - копия страницы, размещенная на разных URL адресах;

- частичные - дублируется часть содержимого.

Полные дубли

Это может быть:

- одинаковые страницы по одинаковым URL адресам с www и без;

- дубли страниц с html и https;

- копии, созданные из-за реферальных ссылок;

- проблемы с иерархией разделов, которые генерируют копии;

- неправильно настроенная страница 404, создающая дубликаты;

- дубли страниц без слеша в конце url.

Частичные дубли

Они обычно появляются из-за особенностей системы управления сайтом, и найти их сложнее.

Чаще всего это:

- Копии, созданные страницами фильтров, сортировок и пагинации. Например, когда пользователь применяет фильтр товаров, URL адрес немного изменяется, и поисковые роботы индексируют эту страницу как отдельную. Но от смены адреса в данном случае контент не изменился.

- Блоки комментариев и описаний. Здесь практически та же ситуация - переход к блоку отзывов, например, создает дополнительный параметр в адресе, но страница остается та же.

- Печать и PDF для загрузки. Такие страницы полностью копируют содержимое веб-сайта.

- Сгенерированные AJAX слепки страниц.

Как обнаружить копии?

Можно проверить сайт на ошибки несколькими способами:

Промониторить выдачу с помощью оператора “site:”

Это метод, позволяющий проверить дубли страниц сайта вручную. Выдачу, отфильтрованную оператором, нужно изучить визуально и выявить копии.

Программы

Существуют разные инструменты для вебмастеров, позволяющие быстро просканировать веб-сайт. Это может быть проверка сайта на дубли страниц онлайн или с помощью десктопных программ. Они выгрузят полный список адресов, который можно будет затем отсортировать и найти дубликаты.

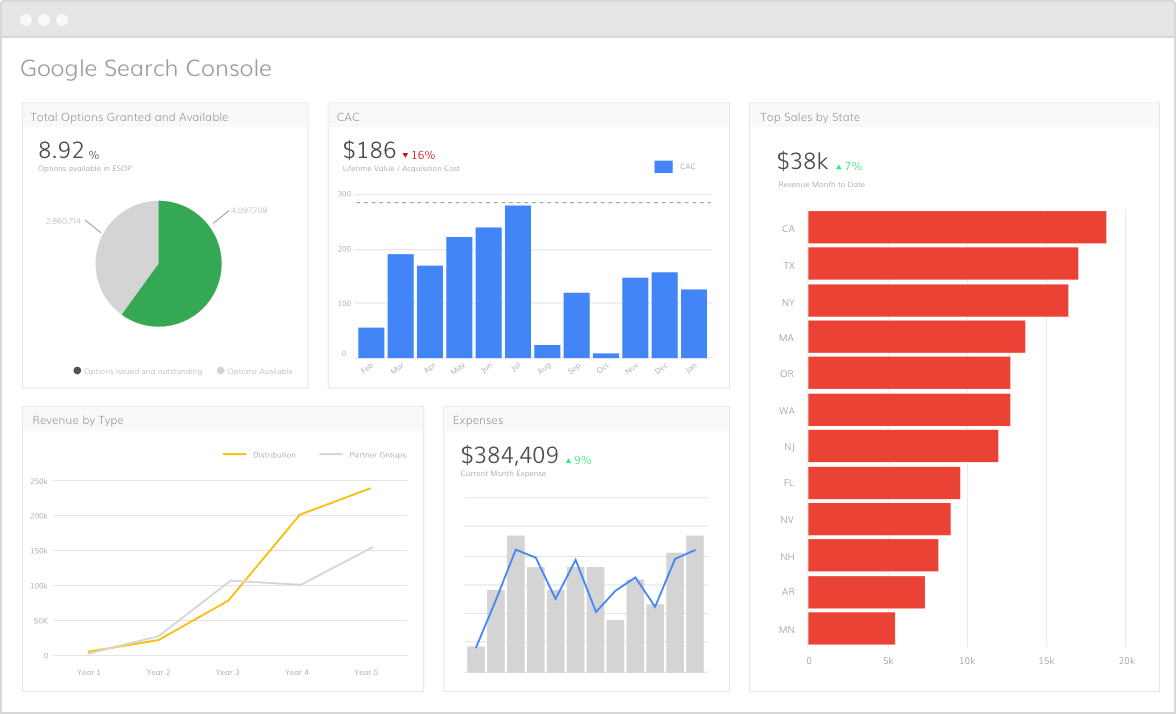

Консоль Google

Google Search Console отображает список повторов мета-описаний и тэгов. Они могут быть признаками копий.

Как избавиться от дубликатов?

Первый и самый очевидный метод - удалить дубли страниц со слешем и другими частями URL адреса, которые создают копии. Также можно запретить роботам индексировать дубликаты, дописав условия в файл “robots.txt”. Это сработает со служебными страницами, которые повторяют содержимое основных.

Еще одно решение - настроить 301 редирект со страницы-дубля на соответствующую корректную страницу сайта. Это поможет с ошибками в иерархии разделов и reff-метками. Также можно проставить тэг “rel=canonical”, что решит проблему с фильтрами, сортировками и пагинацией. А если у вас на веб-сайте есть версии для печати, блоки с отзывами и другой информацией, воспользуйтесь тегом meta name="robots" content="noindex, nofollow". Это позволит скрыть подобные блоки от поисковых ботов.

Чаще всего копии создаются самой системой управления сайтом, поэтому лучше, чтобы выявлением дубликатов и их устранением занимался опытный специалист. Наша команда веб-студии Артджокер обладает большим опытом и крепкими знаниями в поисковой оптимизации и продвижении сайтов. Мы сможем обнаружить все ошибки, которые мешают раскрутке вашего ресурса, и исправить их. Также мы составим эффективную стратегию продвижения, которая позволит быстро добиться желаемых результатов.